Effektives Prompting: Der Schlüssel zur optimalen Nutzung von Large Language Models (LLMs)

Künstliche Intelligenz (KI) hat in den letzten Jahren erhebliche Fortschritte gemacht, sodass selbst Nutzer ohne technisches Vorwissen moderne KI-Modelle wie ChatGPT, Google Gemini, Claude AI, Mistral AI oder Microsoft Copilot einfach einsetzen können – sei es zur Unterstützung im Arbeitsalltag oder für kreative Aufgaben. Diese Modelle sind sogenannte Large Language Models (LLMs).

Diese leistungsstarken KI-Modelle sind darauf trainiert, große Mengen an Textdaten zu verarbeiten und vielseitige Aufgaben zu übernehmen, darunter die Generierung von (kreativen) Texten, das Beantworten von einfachen Fragen, die Übersetzung von Sprachen und die Analyse von Dokumenten. Ein Large Language Model erkennt dabei Zusammenhänge zwischen Wörtern, Sätzen und Konzepten, um Sprache möglichst natürlich zu verarbeiten. Es nutzt komplexe neuronale Netzwerke, die ähnlich wie das menschliche Gehirn lernen, jedoch auf mathematischen Algorithmen basieren.

Der entscheidende Faktor für den erfolgreichen Einsatz dieser Technologie ist die richtige Anwendung von Prompting-Techniken. Ein präzise formulierter Prompt kann den Unterschied zwischen relevanten, präzisen Antworten und unbrauchbaren Ergebnissen ausmachen. Ein schlecht formulierter Prompt kann die Effizienz erheblich einschränken und dazu führen, dass die gewünschten Ziele nicht erreicht werden.

Was ist Prompting und Prompt Engineering?

Prompting beschreibt die Formulierung von Anweisungen an ein LLM oder einen Chatbot, um eine gewünschte Antwort zu erhalten. Es umfasst unterschiedliche Arten von Prompts, darunter Informationsanfragen, kreative Anfragen und Handlungsanweisungen. Prompt Engineering hingegen geht über die bloße Formulierung hinaus und beschäftigt sich mit der gezielten Optimierung von Prompts durch Kontextualisierung, Strukturierung, iterative Verbesserung und spezifische Anweisungen.

Während Prompting als grundlegender Prozess dient, um Modelle zur Bereitstellung von Antworten zu bringen, ist Prompt Engineering ein strategischer Ansatz, um die Qualität und Relevanz der Ergebnisse zu maximieren. Ein gut gestalteter Prompt sollte dabei eine Balance zwischen Präzision und Flexibilität halten, um sowohl genaue als auch kreative Antworten zu ermöglichen.

System Prompt vs. User Prompt

Ein wichtiger Aspekt, den es beim Prompting zu unterscheiden gilt, ist der Unterschied zwischen System Prompts und User Prompts. System Prompts werden vom Entwickler vordefiniert und bestimmen, wie das Modell grundsätzlich arbeitet und reagiert. Sie legen fest, in welcher Rolle das Modell agieren soll, und beeinflussen das generelle Antwortverhalten. Beispielsweise kann ein System Prompt dem Modell vorgeben, stets professionell und freundlich zu antworten. Solche Prompts sind statisch und werden selten geändert, da sie dazu dienen, eine konsistente Grundlage für alle Interaktionen mit dem Modell zu schaffen.

Im Gegensatz dazu stehen die User Prompts, die von den Nutzern selbst eingegeben werden und eine konkrete Frage oder Anweisung enthalten. Diese Prompts sind dynamisch und variieren je nach spezifischer Anfrage des Nutzers. Während ein System Prompt die allgemeine Ausrichtung des Modells vorgibt, bestimmt ein User Prompt, welche konkrete Antwort in einer bestimmten Situation erwartet wird. Ein Nutzer könnte zum Beispiel eine Frage wie „Welche Strategien gibt es zur Verbesserung der Kundenzufriedenheit?“ stellen und so das Modell gezielt zu einer gewünschten Antwort führen.

| System Prompt | User Prompt |

| Vom Entwickler vordefiniert | Vom Nutzer eingegeben |

| Legt die allgemeine Rolle und das Antwortverhalten fest | Enthält eine konkrete Frage oder Anweisung |

| Statisch, wird selten geändert | Dynamisch, variiert je nach Anfrage |

Warum ist effektives Prompting wichtig?

Effektives Prompting trägt maßgeblich dazu bei, dass Large Language Models präzisere Antworten liefern, die besser auf die spezifischen Anforderungen des Unternehmens abgestimmt sind. Durch gut durchdachte Prompts lassen sich nicht nur Zeit- und Kostenaufwände reduzieren, sondern auch Prozesse effizienter gestalten. Zudem ermöglicht gezieltes Prompting die Automatisierung wiederkehrender Aufgaben und die Optimierung interner Abläufe, was die Unternehmensleistung erheblich steigern kann.

Warum Prompting weiterhin entscheidend ist

Obwohl Large Language Models (LLMs) durch ihr Training bereits über umfangreiche Fähigkeiten verfügen, ist das Prompting ein entscheidender Faktor für die Qualität der Ergebnisse. Prompting bezeichnet die gezielte Formulierung von Fragen oder Aufgaben, die das LLM in eine bestimmte Richtung lenken können, um die gewünschten Antworten zu erhalten. Dieser Prozess ist nicht nur wichtig, um die Ergebnisse zu optimieren, sondern auch um die richtigen Fragen zu stellen, die das LLM effektiv beantworten kann.

Zum einen ermöglicht Prompting die Steuerung der Ausgabe. Ein gezieltes und strukturiertes Prompting kann das LLM anleiten, eine Antwort in die gewünschte Richtung zu geben. Zum Beispiel kann ein einfacher Prompt wie „Erkläre das Konzept von Angebot und Nachfrage“ zu unzureichenden oder missverständlichen Antworten führen, wenn der Kontext nicht ausreichend ist. Ein strukturierteres Prompting, das den Rahmen vorgibt, wie „Erkläre das Konzept von Angebot und Nachfrage anhand eines alltäglichen Beispiels, wie der Preisentwicklung von Konzerttickets“, erhöht die Wahrscheinlichkeit einer korrekten und verständlichen Antwort erheblich.

Kontextualisierung ist ein weiterer wichtiger Aspekt des Prompting. Ein LLM ohne den notwendigen Kontext kann zu irreführenden oder irrelevanten Antworten führen. Ein effektiver Prompt liefert dem LLM den notwendigen Kontext, um spezifische und relevante Antworten zu geben. Zum Beispiel kann ein Prompt wie „Wir betreiben einen kleinen Online-Shop für handgefertigte Möbel und möchten Produktbeschreibungen schneller und ansprechender erstellen. Wie kann generative KI uns dabei unterstützen?“ den LLM in den Kontext der spezifischen Anforderungen des Unternehmens stellen und somit zu zielführenden Antworten führen.

Die Qual der Wahl: Vielfalt der Prompting-Techniken

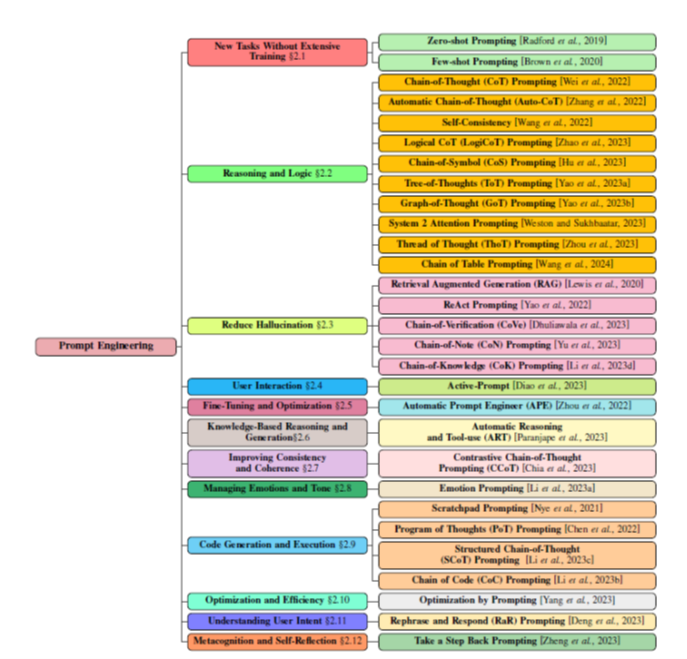

Abbildung 1: Sahoo, P., Singh, A. K., Saha, S., Jain, V., Mondal, S., & Chadha, A. (2024). A systematic survey of prompt engineering in large language models: Techniques and applications. arXiv preprint arXiv:2402.07927

Die Vielzahl der verfügbaren Prompting-Techniken macht es oft schwierig, die richtige Methode für eine bestimmte Anwendung zu wählen. Wie in der bereitgestellten Taxonomie ersichtlich, gibt es eine breite Palette von Techniken, die unterschiedliche Ziele verfolgen. Manche Techniken, wie Zero-shot oder Few-shot Prompting, ermöglichen schnelle und unkomplizierte Ergebnisse, während fortgeschrittenere Methoden wie Chain-of-Thought oder Retrieval Augmented Generation (RAG) ein tieferes Verständnis und mehr Kontextintegration erfordern. Allerdings sind einige dieser Techniken nicht durch einfaches Prompten für Endnutzer umsetzbar, da sie spezialisierte Implementierungen oder Anpassungen im Hintergrund seitens der Anbieter erfordern. In diesem Beitrag wird der Fokus auf zwei Techniken gelegt – eine einfache und eine komplexere Methode –, die direkt anwendbar sind und ohne tiefgehendes technisches Wissen genutzt werden können.

Die R-U-F-E-Technik

Die R-U-F-E-Technik [1] ist eine praktische und effektive Methode zum Prompt Engineering, die sich insbesondere für klein und mittelständische Unternehmen eignet. Sie bietet eine strukturierte Herangehensweise an die Erstellung von Prompts, um die Ergebnisse von Large Language Models (LLMs) zu optimieren. Die Methode umfasst vier Hauptbestandteile: Rolle, Umsetzung, Format und Erläuterung.

Die Rolle beschreibt den Charakter, den das LLM einnehmen soll. Sie definiert, wie das LLM sich verhalten und sprechen soll. Zum Beispiel könnte die Rolle “Marketingexperte” angeben, dass das LLM sich wie ein erfahrener Marketingexperte verhalten soll, der wertvolle Ratschläge und Strategien bereitstellen kann.

Die Umsetzung beschreibt die Aufgabe, die das Modell ausführen soll. Sie legt fest, was das LLM konkret tun soll. Zum Beispiel könnte die Umsetzung “Erstellen Sie drei Strategien zur Erhöhung der Kundenzufriedenheit” angeben, dass das LLM drei konkrete Strategien entwickeln soll, die die derzeitigen Kunden zufriedenstellen können.

Das Format gibt vor, wie die Antwort des LLMs strukturiert sein soll. Dies kann zum Beispiel eine spezifische Formatierung wie “als Tabelle” oder “als Liste” vorgeben. Dadurch kann der Nutzer die Antwort leichter verstehen und anwenden.

Die Erläuterung gibt dem LLM den notwendigen Kontext, damit es die Anfrage besser versteht und eine präzisere, passendere Antwort generiert. Sie kann Informationen über die spezifische Situation oder das Unternehmen enthalten, in dem der Prompt verwendet wird. Zum Beispiel könnte eine Erläuterung wie „Wir sind ein kleines Handwerksunternehmen und suchen nach digitalen Lösungen, um unsere Arbeitsabläufe effizienter zu gestalten“ dem LLM helfen, die Antwort gezielt auf die Bedürfnisse dieses Unternehmens auszurichten und praxisnahe Vorschläge zu liefern.

Beispiel für die Anwendung der R-U-F-E-Technik

Um die praktische Anwendung der R-U-F-E-Methodik zu illustrieren, werden nachfolgend verschiedene „einfache Prompts“ und deren Pendant nach der RUFE-Technik vergleichen.

| Einfacher Prompt | Mit „RUFE“ optimierter Prompt |

| Wie verbessere ich den Kundenservice? | Agiere als Experte für Kundendienst [R], erkläre drei effektive Strategien zur Verbesserung des Kundenservices [U], und präsentiere die Informationen in einem kurzen aber präzisen Bericht [F]. Wir sind ein kleiner Handwerksbetrieb (SHK) [E] |

| Wie steigere ich die Mitarbeiterzufriedenheit? | Agiere als HR-Berater [R], nenne fünf Strategien zur Steigerung der Mitarbeiterzufriedenheit [U], und präsentiere die Informationen in einer Tabelle. [F] Wir sind ein mittelständischer Produktionsbetrieb in Hamburg. [E] |

Nehmen Sie sich einen Moment Zeit und testen Sie die Wirkung der R-U-F-E-Technik in der Praxis. Kopieren Sie die beiden oben stehenden Prompts – den einfachen und den optimierten – und geben Sie sie in einen KI-Chatbot Ihrer Wahl ein. Vergleichen Sie die Ergebnisse und erleben Sie den Unterschied in Klarheit, Struktur und Relevanz. Welcher Prompt liefert Ihnen präzisere und hilfreichere Antworten?

Tipp: Probieren Sie es auch mit einem Prompt, den Sie kürzlich selbst verwendet haben. Optimieren Sie ihn mit der R-U-F-E-Technik und sehen Sie, wie sich die Qualität der Antwort verändert.

Das K-O-N-S-T-R-U-K-T(-E)-Framework: Struktur und Anwendung

Das K-O-N-S-T-R-U-K-T(-E)-Framework ist eine erweiterte Methode des Prompt Engineerings, die die R-U-F-E-Methodik um weitere Aspekte ergänzt, um die Ergebnisse von Large Language Models (LLMs) zu optimieren. Entwickelt am Forschungs- und Transferzentrum Business Innovation Lab der HAW Hamburg, priorisiert das Framework eine strukturierte und umfassende Herangehensweise, wodurch die Qualität und Relevanz der generierten Antworten erheblich verbessert werden kann.

Das K-O-N-S-T-R-U-K-T(-E)-Framework umfasst die folgenden Schlüsselbestandteile:

K – Kontext

Der Kontext umfasst alle notwendigen Hintergrundinformationen, die dem LLM helfen, die spezifische Fragestellung richtig einzuordnen und eine maßgeschneiderte Antwort zu generieren. Ein klar definierter Kontext liefert wichtige Details über das Unternehmen, die Branche, die Problemstellung oder die Rahmenbedingungen der Aufgabe. Je detaillierter der Kontext ist, desto besser kann das Modell die gewünschte Antwort generieren, die exakt auf die Bedürfnisse des Nutzers zugeschnitten ist.

O – Operatives Ziel

Das operative Ziel beschreibt die genaue Aufgabe, die das LLM erfüllen soll. Es definiert, welches Problem gelöst werden soll, welche Ergebnisse erwartet werden und in welchem Format die Antwort geliefert werden sollte. Eine klare Zielsetzung ist essenziell, um präzise, relevante und praxisnahe Antworten zu erhalten.

N – Nutzer (Audience)

Die Definition der Nutzergruppe stellt sicher, dass die Antwort auf die spezifischen Bedürfnisse der Zielgruppe zugeschnitten ist. Unterschiedliche Nutzer benötigen unterschiedliche Arten von Antworten – beispielsweise benötigen Manager strategische Empfehlungen, während operative Teams klare Anweisungen und praxisnahe Tipps bevorzugen.

S – Stil

Der Stil legt fest, in welcher sprachlichen und formalen Gestaltung die Antwort präsentiert wird. Je nach Anwendungsfall kann ein formeller, wissenschaftlicher, technischer oder auch ein lockerer, ansprechender Stil erforderlich sein. Eine konsistente Stilwahl trägt dazu bei, dass die Antwort zur Zielgruppe passt und verständlich bleibt.

T – Ton

Der Ton beschreibt die emotionale Färbung der Antwort. Je nach Kontext kann eine Antwort neutral, unterstützend, motivierend oder auch warnend formuliert sein. Die Wahl des richtigen Tons kann die Akzeptanz und Wirksamkeit der Antwort erheblich beeinflussen.

R – Resultat

Das Resultat beschreibt, in welcher Form die Antwort geliefert werden soll. Eine Antwort kann beispielsweise als ausführlicher Bericht, eine Liste mit Stichpunkten, ein Diagramm oder eine tabellarische Übersicht dargestellt werden. Die Formatierung des Ergebnisses beeinflusst, wie gut es von der Zielgruppe verstanden und genutzt werden kann.

U – Umfang

Der Umfang definiert die Grenzen der Aufgabe, also welche Aspekte berücksichtigt und welche ausgeklammert werden. Dies kann beispielsweise die Länge der Antwort, die Tiefe der Analyse oder bestimmte Einschränkungen hinsichtlich der verwendeten Quellen betreffen.

K – Klare Logik

Die logische Strukturierung der Antwort stellt sicher, dass die Gedankengänge und Argumente in einer nachvollziehbaren Reihenfolge präsentiert werden. Dies erleichtert das Verständnis und erhöht die Glaubwürdigkeit der Antwort. Methoden wie „Chain of Thought“ helfen dabei, die Argumentation schrittweise aufzubauen.

T – Transparenz

Transparenz bedeutet, dass die Antwort nachvollziehbar bleibt und auf verlässlichen Quellen oder klar formulierten Annahmen basiert. Dies erhöht die Vertrauenswürdigkeit der generierten Inhalte und gibt dem Nutzer die Möglichkeit, die Argumentation nachzuvollziehen.

(E) – Exemple

Beispiele veranschaulichen die theoretischen Inhalte und machen die Antwort greifbarer. Durch praxisnahe Vergleiche kann das Verständnis erleichtert und die Umsetzbarkeit der Vorschläge verdeutlicht werden.

Das K-O-N-S-T-R-U-K-T(-E)-Framework ermöglicht es Unternehmen, LLMs auf eine viel umfassendere und präzisere Weise anzusprechen. Es bietet eine strukturierte Herangehensweise, die die Qualität und Relevanz der generierten Antworten verbessern kann. Diese erweiterten Aspekte ermöglichen es Unternehmen, die spezifischen Bedürfnisse ihrer Anwendungen besser zu adressieren und somit den maximalen Nutzen aus LLMs zu ziehen.

Beispiel für die Anwendung des K-O-N-S-T-R-U-K-T(-E)-Frameworks

Um die praktische Anwendung des K-O-N-S-T-R-U-K-T(-E)-Frameworks zu illustrieren, können wir ein Beispiel betrachten:

„Die „EcoClean GmbH“ ist ein mittelständisches Unternehmen, das umweltfreundliche Reinigungsprodukte herstellt. Der Marketingmanager, Herr Müller, plant eine Social-Media-Kampagne zur Einführung eines neuen Produkts: eines biologisch abbaubaren Allzweckreinigers namens „EcoPure“. Dieses Produkt zeichnet sich durch seine hohe Wirksamkeit und vollständige Umweltverträglichkeit aus. Das Unternehmen hat kürzlich eine Auszeichnung für nachhaltige Produktion erhalten. Die Zielgruppe sind umweltbewusste Verbraucher im Alter von 25 bis 45 Jahren. Herr Müller benötigt kreative Ideen für Werbetexte und Hashtags, die diese Aspekte hervorheben.“

Prompt mit K-O-N-S-T-R-U-K-T(-E)-Framework:

„Wir sind die EcoClean GmbH, ein Unternehmen, das umweltfreundliche Reinigungsprodukte herstellt. [K] Erstelle kreative Werbetexte und passende Hashtags für unsere Social-Media-Kampagne zur Einführung unseres neuen biologisch abbaubaren Allzweckreinigers ‚EcoPure‘. [O] Die Texte sollen speziell auf umweltbewusste Verbraucher zwischen 25 und 45 Jahren ausgerichtet sein, die Wert auf Nachhaltigkeit legen. [N] Schreibe im kreativen und ansprechenden Stil [S] und verwende einen positiven, inspirierenden Ton. [T] Das Ergebnis sollte eine Liste von mindestens fünf Werbetexten mit dazugehörigen Hashtags sein. [R] Fokussiere dich dabei auf die Umweltfreundlichkeit und Effektivität des Produkts. [U] Erläutere Schritt-für-Schritt dein Vorgehen bei der Erstellung der Werbetexte. [K] Lege die Annahmen über die Vorlieben unserer Zielgruppe und aktuelle Marketingtrends offen. [T] Als Beispiel für unsere bisherige Kommunikation füge ich unsere letzte Kampagne an. [E]“

Prompt nach der R-U-F-E-Technik:

- Rolle: Agiere als erfahrener Digital-Marketing-Experte.

- Umsetzung: Entwickle kreative Werbetexte und passende Hashtags für die Social-Media-Kampagne zur Einführung unseres neuen biologisch abbaubaren Allzweckreinigers.

- Format: Präsentiere mindestens fünf Werbetexte mit dazugehörigen Hashtags in einer Liste.

- Erläuterung: Wir sind die EcoClean GmbH, ein mittelständisches Unternehmen, das umweltfreundliche Reinigungsprodukte herstellt. Unser neues Produkt „EcoPure“ ist ein biologisch abbaubarer Allzweckreiniger. Unsere Zielgruppe sind umweltbewusste Verbraucher im Alter von 25 bis 45 Jahren. Wir haben kürzlich eine Auszeichnung für nachhaltige Produktion erhalten.

Testen Sie die Anwendung des K-O-N-S-T-R-U-K-T(-E)-Frameworks und der R-U-F-E-Technik in der Praxis. Nehmen Sie den folgenden Beispiel-Prompt und geben Sie ihn in einen KI-Chatbot Ihrer Wahl ein. Vergleichen Sie die generierten Antworten mit einem einfachen Prompt, um den Unterschied in Struktur, Detailliertheit und Relevanz zu erkennen. Welcher Prompt liefert Ihnen präzisere und hilfreichere Ergebnisse?

Tipp: Versuchen Sie es auch mit einem Ihrer eigenen Prompts, den Sie kürzlich verwendet haben. Optimieren Sie ihn mithilfe des K-O-N-S-T-R-U-K-T(-E)-Frameworks und der R-U-F-E-Technik und beobachten Sie, wie sich die Qualität und Tiefe der Antworten verändert, beachten sie dabei aber auch den benötigten Aufwand.

Quellen

[1] frei nach „The R-T-F Framework“, Jeffrey Zheng, McKinsey, 2023, https://x.com/thejeffreyzheng/status/1660223969755111427

Fazit

Durch den gezielten Einsatz der R-U-F-E- und K-O-N-S-T-R-U-K-T(-E)-Methodik können kleine und mittlere Unternehmen (KMU) die Möglichkeiten von Large Language Models (LLMs) optimal nutzen. Beide Techniken tragen dazu bei, die Qualität der generierten Inhalte zu verbessern und die Nutzung der Technologie effizienter zu gestalten.

Die R-U-F-E-Methodik bietet einen einfachen, praxisnahen Ansatz, mit dem Unternehmen ohne tiefgehende Vorkenntnisse schnell zu relevanten Ergebnissen gelangen. Sie lässt sich flexibel in verschiedenen Unternehmensbereichen einsetzen und erfordert nur eine kurze Einarbeitungszeit, um effektiv angewendet zu werden.

Das K-O-N-S-T-R-U-K-T(-E)-Framework hingegen ermöglicht eine tiefere und detailliertere Strukturierung der Prompts, was insbesondere bei komplexeren oder wiederkehrenden Aufgaben von Vorteil ist. Es erfordert zwar einen höheren initialen Aufwand, liefert aber präzisere und besser optimierbare Ergebnisse, die langfristig einen hohen Mehrwert bieten.

Die Wahl zwischen den beiden Methoden hängt von den individuellen Anforderungen ab: Während R-U-F-E eine schnelle und intuitive Lösung für alltägliche Anfragen bietet, ist K-O-N-S-T-R-U-K-T(-E) besonders für anspruchsvolle, strategische Anwendungsfälle geeignet.

Wer sich intensiver mit diesen Themen auseinandersetzen möchte, kann die vielfältigen Angebote des Mittelstand-Digital Zentrums Hamburg nutzen. Das Zentrum bietet zahlreiche Veranstaltungen rund um die digitale Transformation, darunter Workshops zu KI und Prompt Engineering. Interessierte Unternehmen haben zudem die Möglichkeit, individuelle Fragen direkt mit KI-Trainern zu besprechen oder an der KI-Sprechstunde teilzunehmen.

Weiterführende Ressourcen

Für diejenigen, die mehr über effektives Prompting und Large Language Models (LLMs) erfahren möchten, stehen eine Vielzahl von Ressourcen bereit, die weitere Einblicke und Informationen bieten. Einige empfehlenswerte Quellen sind:

- Prompting Guide AI Bietet eine umfassende Einführung in das Prompt Engineering und dessen Anwendung, inklusive Best Practices und Beispiele.

- OpenAI Prompt Engineering Enthält Blogbeiträge, Whitepapers und Tutorials zu Grundlagen und fortgeschrittenen Techniken.

- Anthropic Claude Prompting Erklärt das Prompt Engineering für das Claude-Modell und bietet praxisnahe Beispiele.

Weiterführende Links:

- Erstellung von Prompts durch andere Chatbots mit speziellen Meta-Prompts:

- Prompt Templates für wiederkehrende Aufgaben:

- Prompt Sammlungen / Datenbanken:

Unser kostenfreies Unterstützungsangebot für Sie

Benötigen Sie Unterstützung zum Thema effektives Prompting? Ob offene Fragen oder konkrete Problemstellungen, die Sie gern mit uns angehen möchten – unsere Expert:innen helfen Ihnen gern weiter. Kontaktieren Sie uns gern unter mittelstand-digital@haw.de