Demonstrator zur visuellen Qualitätskontrolle mit KI

Ausgangslage

Die Produktionsprozesse in modernen Fertigungsunternehmen werden durch innovative Technologien stetig weiterentwickelt, sodass Effizienz, Präzision und Qualität kontinuierlich gesteigert werden. HellermannTyton, ein weltweit führender Hersteller von hochwertigen Lösungen im Bereich Kabelmanagement, Verbindungstechnik und industrieller Kennzeichnung, hat dabei ein hochmodernes, pixelbasiertes Qualitätssystem eingeführt, das sämtliche potenzielle Defekte zuverlässig erfasst. Das Unternehmen, das 1935 in Hamburg gegründet wurde und seit 2000 seinen Sitz in Tornesch hat, bietet Lösungen für Branchen wie die Automobilindustrie, den Maschinenbau, die Luft- und Raumfahrt, die Elektroinstallation und die Telekommunikation.

Abbildung 1:

EdgeClip (links) mit Kabelbinder

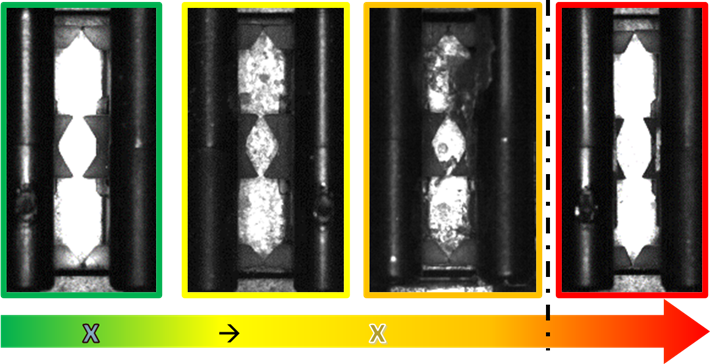

Durch das hohe Qualitätsversprechen von HellermannTyton wird jedes Produkt mit höchster Präzision geprüft. Besonders die visuelle Kontrolle des EdgeClip, einer Kabelhalterungslösung für die Kantenmontage, stellt dabei eine Herausforderung dar. Diese Halterung, die aus einem widerstandsfähigen Kunststoffgehäuse mit integrierter Federstahlklammer besteht, ermöglicht eine zuverlässige und flexible Befestigung und wird vor allem in der Automobil- und Maschinenbauindustrie geschätzt. Das bestehende System sorgt bereits für eine sehr hohe Qualitätsprüfung, dennoch stößt es bei der präzisen Unterscheidung zwischen tatsächlichen Defekten und Pseudoausschuss an seine Grenzen. Pseudoausschuss bezeichnet in diesem Kontext fehlerfrei produzierte Bauteile, die fälschlicherweise als Ausschuss klassifiziert werden. Dies kann durch optische Effekte wie Reflexionen, Glanzstellen oder Verunreinigungen verursacht werden, die das Prüfsystem als Defekt interpretiert, obwohl das Bauteil in einwandfreiem Zustand ist. Zudem führen Schmutz- und Staubpartikel, Zinksplitter oder verschmutzte Beschichtungen zu fehlerhaften Klassifizierungen. Auch minimale Abweichungen in Geometrie, Abmessungen oder Chargenunterschiede stellen für das System eine Herausforderung dar. Da Mikrofehlerabweichungen nahezu unendlich viele Variationen aufweisen und oft eine glatte Struktur haben, wird eine eindeutige Klassifizierung erschwert. Im Rahmen des Projekts wird daher daran gearbeitet, die Pseudoausschussrate weiter zu senken und damit die Effizienz und Nachhaltigkeit der Produktion zu steigern.

Abbildung 2:

Verschmutzungsgrade des EdgeClips

In diesem Kontext wurde ein Pilotprojekt ins Leben gerufen, um den Einsatz künstlicher Intelligenz, speziell Convolutional Neural Networks (CNN), in der visuellen Qualitätskontrolle zu erproben. Ziel war es, ein System zu entwickeln, das in Echtzeit Bilder von Produktionsprozessen auswerten kann, um fehlerhafte Teile zuverlässig zu identifizieren. Zur Umsetzung wurde ein prototypischer Anlagen-Nachbau realisiert, der typische Produktionsbedingungen simuliert. Dabei wurden hochauflösende Industriekameras, ein Drehteller mit pneumatischer Steuerung und eine modulare IT-Architektur eingesetzt, um eine realitätsnahe Testumgebung zu schaffen.

Herausforderungen

Die Integration einer visuellen Qualitätskontrolle mit KI in eine bestehende Produktionsumgebung stellte sowohl technische als auch organisatorische Herausforderungen dar. Eine der zentralen Anforderungen bestand darin, dass das KI-Modell Bilder in Echtzeit analysieren sollte, um den Produktionsfluss nicht zu behindern. Dies bedeutete, dass die Verarbeitung innerhalb von max. 200 Millisekunden erfolgen musste. Um diese Vorgabe zu erfüllen, war die Auswahl geeigneter Edge-Computing-Geräte und entsprechender KI-Modelle entscheidend. Hier mussten Systeme gefunden werden, die sowohl leistungsstark als auch kosteneffizient waren, wie etwa die NVIDIA Jetson Plattform oder vergleichbare Lösungen. Gleichzeitig musste das KI-Modul nahtlos in die bestehende Maschinensteuerung integriert werden. Dies erforderte standardisierte Schnittstellen, um eine reibungslose Kommunikation zwischen der KI und den Steuerungssystemen zu gewährleisten.

Ein weiteres wesentliches Problem war die Datenqualität und -vorbereitung. Die Erfassung von 20.000 Bildern in einer Produktionsumgebung stellte Herausforderungen hinsichtlich Konsistenz und Qualität dar. Faktoren wie unterschiedliche Lichtverhältnisse, variierende Auflösungen und Bewegungsunschärfen mussten systematisch adressiert werden. Zudem war die manuelle Klassifikation und Annotation der Bilder essenziell, um eine einheitliche und qualitativ hochwertige Datenbasis für das Training des KI-Modells zu schaffen. Dies erforderte präzise Tools und klar definierte Kriterien, um Fehlklassifikationen zu minimieren.

Die Modellrobustheit und die Anpassung mittels Transferlernen bildeten eine weitere Herausforderung. Das vorab trainierte KI-Modell musste für die spezifischen Produktionsbedingungen optimiert werden. Dabei war es besonders wichtig, dass das Modell auch bei veränderten optischen Rahmenbedingungen, wie unterschiedlichen Kamerawinkeln oder variierender Lichtintensität, stabile Ergebnisse liefern konnte. Eine iterative Optimierung war notwendig, um Fehlklassifikationen, insbesondere unter extremen Lichtverhältnissen, systematisch zu analysieren und die gewonnenen Erkenntnisse in den Trainingsprozess zurückzuführen.

Neben den technischen Herausforderungen spielten die betriebliche Einbindung und Akzeptanz der neuen Technologie eine entscheidende Rolle. Dies umfasste nicht nur die Handhabung des Systems, sondern auch das Verständnis für dessen Funktionsweise und die Interpretation der Ergebnisse.

Vorgehen

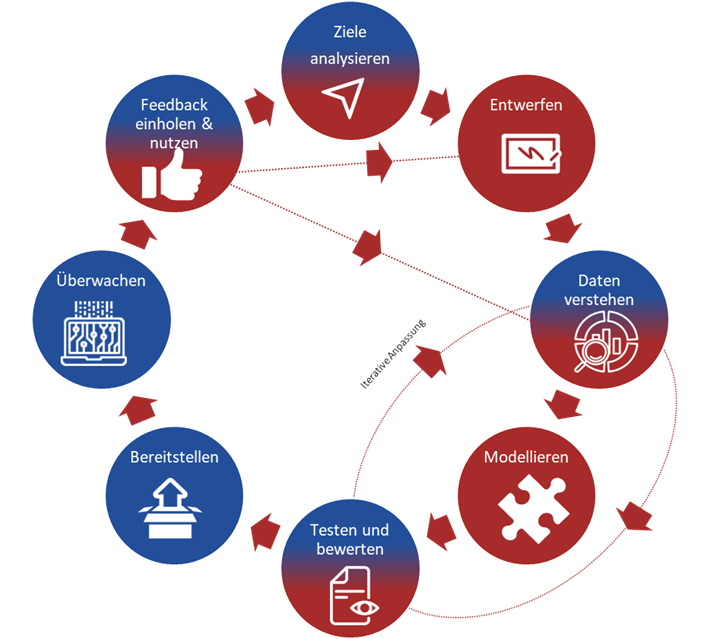

Abbildung 3:

Agiles Vorgehensmodell nach CRISP-DM

Um die Herausforderungen der Integration einer visuellen Qualitätskontrolle mit KI zu bewältigen, wurde ein strukturiertes und iteratives Vorgehen entwickelt, das sowohl technische als auch organisatorische Aspekte berücksichtigte. Dabei wurde berücksichtigt, dass der Prozess nicht strikt linear verläuft, sondern fortlaufend angepasst wird, insbesondere durch häufige Rücksprache zwischen ML- und Fach-Experten. Dort wurden detaillierte Anforderungen definiert und ein umfassendes Konzept erstellt. Dieses umfasste die Entwicklung einer modularen Systemarchitektur mit einem Datenerfassungsmodul, einem zentralen KI-Analysemodul und einer Schnittstelle zur Maschinensteuerung. Zudem wurde eine Datenpipeline zur automatisierten Bilddatenerfassung und Vorverarbeitung definiert, um Bildrauschen zu reduzieren und Kontraste anzupassen

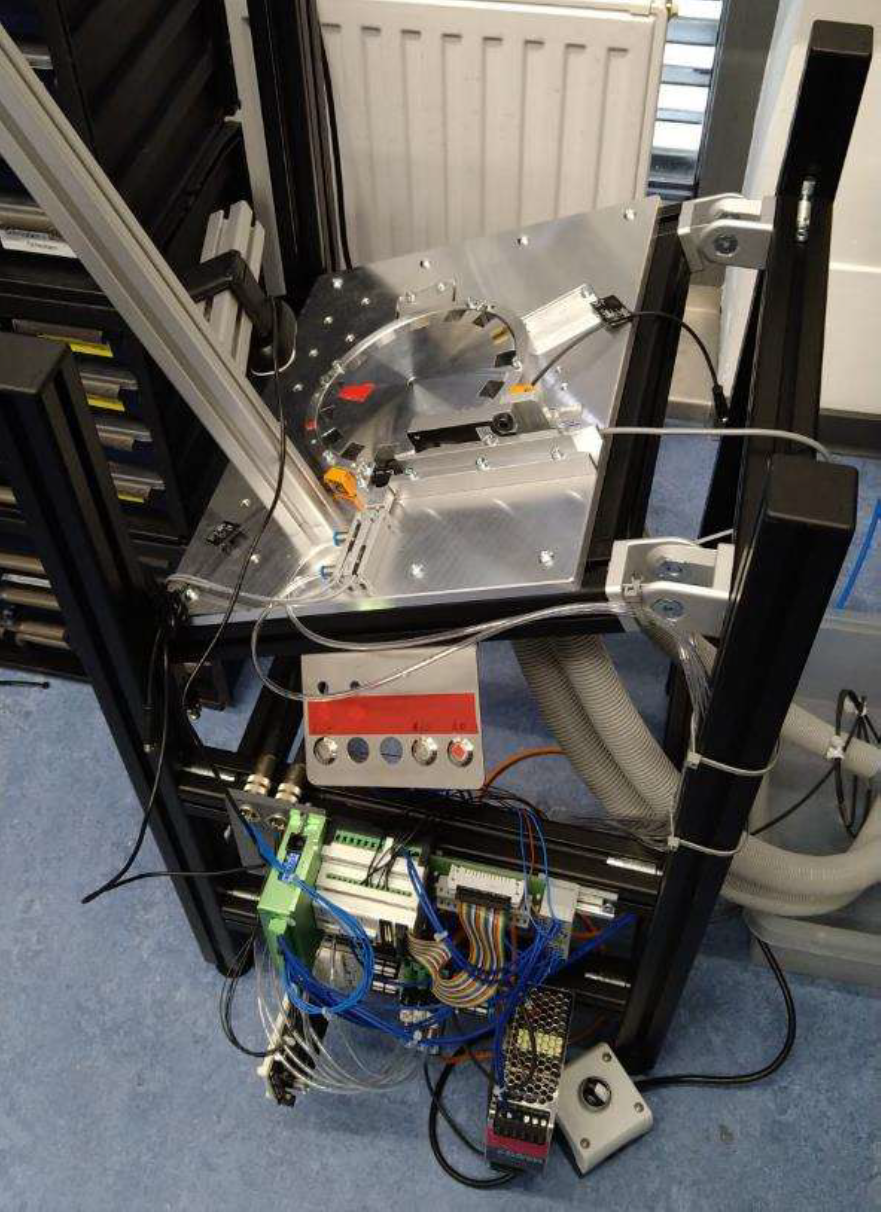

Abbildung 4:

Prototyp mit pneumatischem Drehteller

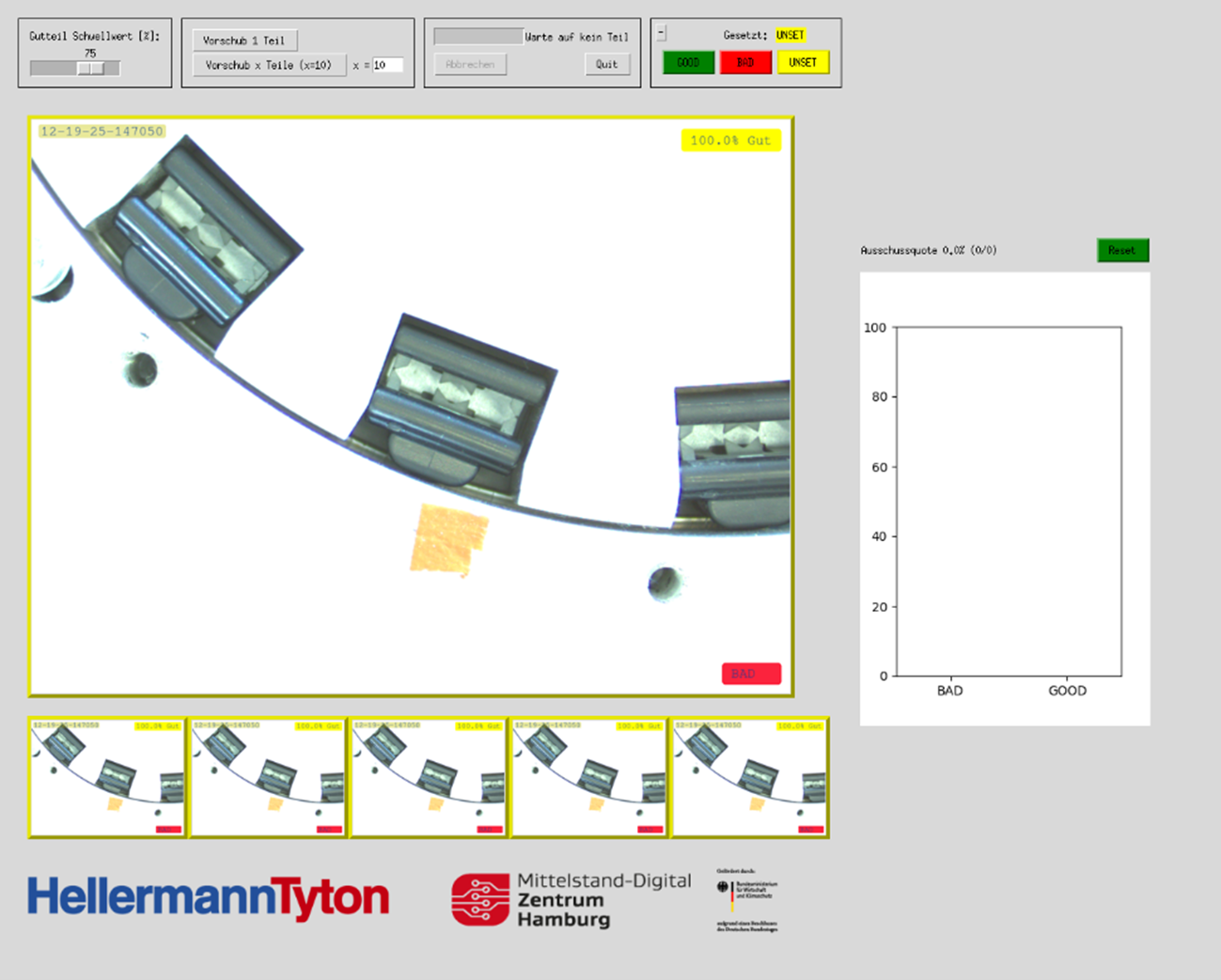

Ein zentrales Ergebnis des Projekts war der prototypische Nachbau der Produktionslinie, der als Testumgebung zur Validierung der Qualitätskontrolle mit KI diente. Zusätzlich wurde ein Echtzeit-Monitoring-Dashboard in das System integriert, das eine kontinuierliche Evaluierung und Validierung der KI-gestützten Analyse ermöglicht. Dieses Dashboard erlaubt nicht nur die Visualisierung wichtiger Produktionskennzahlen, sondern bietet auch eine semiautomatisierte Generierung neuer Trainingsdaten. Dabei werden Bilder automatisch erfasst und mithilfe vordefinierter Labels versehen, sodass daraus ein datenbankbasierter Datensatz für das Training neuer KI-Modelle entsteht. Darüber hinaus können bestehende Klassifikationsentscheidungen überprüft und mit realen Teilebewertungen verglichen werden, wodurch eine iterative Verbesserung der bestehenden KI-Systeme möglich wird. Dieser Prototyp bestand aus einem Drehteller mit pneumatischer Steuerung, der eine flexible Simulation variabler Geschwindigkeiten und Positionen ermöglichte. Dadurch konnten realistische Produktionsbedingungen nachgestellt werden, um die Leistungsfähigkeit der KI-gestützten Analyse unter unterschiedlichen Szenarien zu testen. Zur Sicherstellung einer detaillierten Bildaufnahme wurden mehrere hochauflösende Industriekameras strategisch positioniert, sodass verschiedene Blickwinkel und Lichtverhältnisse optimal erfasst wurden. Diese vielseitige Kamerainfrastruktur ermöglichte eine umfassende Erfassung der Bauteile in unterschiedlichen Produktionssituationen. In einem definierten Zeitraum wurden rund 20.000 Bilder aus dem Produktionsprozess gesammelt und mithilfe spezialisierter Annotationstools in „Gut-Teile“ und „Schlecht-Teile“ kategorisiert. Die Bilder wurden anschließend vorverarbeitet, wobei Filter zur Rauschreduzierung, Kontrastanpassungen und Skalierungsanpassungen angewandt wurden, um eine konsistente Datenbasis für das Modelltraining zu schaffen.

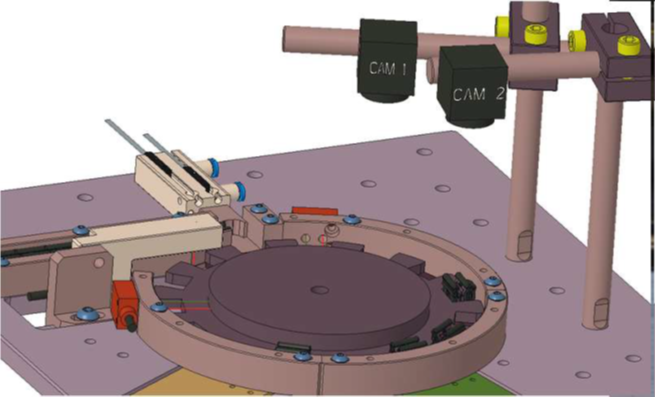

Abbildung 5:

CAD-Zeichnung des Prototyps mit mehreren Kameras

Die technische Umsetzung umfasste die Entwicklung der Systemarchitektur in einer modularen Container-Umgebung, beispielsweise mit Docker, um eine flexible Skalierung und einfache Integration in bestehende IT-Landschaften zu gewährleisten. Das Datenerfassungsmodul wurde so konzipiert, dass es einen Live-Zugriff auf die Kameras ermöglichte und Bilder in Echtzeit vorverarbeitete. Das zentrale KI-Analysemodul basierte auf einem Convolutional Neural Network (CNN), das durch Transferlernen an die spezifischen Produktionsbedingungen angepasst wurde. Umfangreiche Hyperparameter-Tuning-Prozesse, wie die Anpassung von Lernraten, Batch-Größen und Netzwerkarchitekturen, verbesserten die Modellgenauigkeit stetig. Die Anbindung an die Produktionssteuerung erfolgte über eine REST-API, wodurch die Analyseergebnisse direkt in den Produktionsprozess integriert wurden. Zur Sicherstellung der Echtzeitfähigkeit kamen leistungsstarke Edge-Computing-Geräte zum Einsatz, die über GPIO-Schnittstellen direkt mit der Maschinensteuerung verbunden wurden. Benchmark-Tests zeigten, dass die Inferenzzeiten konstant unter 200 Millisekunden lagen und somit der Produktionsfluss nicht beeinträchtigt wurde.

Abbildung 6:

Grafische Benutzeroberfläche des Dashboards

In der anschließenden Test-, Validierungs- und Optimierungsphase wurden unterschiedliche Produktionsbedingungen simuliert, um die Robustheit des KI-Modells zu überprüfen. Dazu gehörten Tests unter verschiedenen Lichtverhältnissen, etwa bei natürlichem Licht, künstlicher Beleuchtung und Helligkeitsunterschieden. Zudem wurde der Einfluss von Bewegungsunschärfe und wechselnden Blickwinkeln analysiert. Fehlklassifikationen, die unter ungünstigen Bedingungen auftraten, wurden detailliert analysiert und in weitere Trainingszyklen integriert, um das Modell kontinuierlich zu verbessern.

Erkenntnisse

Das Projekt lieferte wertvolle und praxisrelevante Erkenntnisse, die sowohl technische als auch organisatorische Aspekte betreffen. Besonders die technische Leistungsfähigkeit und der Echtzeitbetrieb des Systems stellten wesentliche Erfolgsfaktoren dar. Durch den iterativen Trainingsprozess und den Einsatz von Transferlernen konnte eine Klassifikationsgenauigkeit von über 95 % erreicht werden, was verdeutlicht, dass das KI-Modell fehlerhafte Teile mit hoher Zuverlässigkeit identifiziert. Zudem wurde durch die Auswahl geeigneter Edge-Computing-Hardware und die optimierte Systemarchitektur eine Inferenzzeit von unter 200 Millisekunden realisiert, sodass der Produktionsfluss in keiner Weise beeinträchtigt wurde.

Das Projekt zeigte zudem, dass das entwickelte KI-System eine hohe Anpassungsfähigkeit und Flexibilität aufweist. Durch Transferlernen ließ sich das Modell effizient an spezifische Produktionsbedingungen anpassen. Dennoch wurde deutlich, dass regelmäßige Nachtrainingszyklen erforderlich sind, da sich optische Rahmenbedingungen, wie wechselnde Lichtverhältnisse, speziell Schattenwürfe, oder unterschiedliche Kameraperspektiven, im Produktionsalltag stetig verändern. Diese kontinuierliche Anpassung ist essenziell, um die langfristige Leistungsfähigkeit des Modells zu gewährleisten.

Zusammenfassend konnte durch das Projekt gezeigt werden, dass eine visuelle Qualitätskontrolle mit KI nicht nur technisch realisierbar ist, sondern durch gezielte Optimierungsmaßnahmen eine effiziente und verlässliche Integration in bestehende Produktionsprozesse ermöglicht werden kann. Außerdem zeigte das Projekt, dass der Aufwand zum Training, sowie zur Implementierung von Systemen für die Inferenz durch ein breites und kostengünstiges Angebot von Software-Bibliotheken und Hardware für die Inferenz auch für KMU tragbar geworden ist. Aufgrund der positiven Ergebnisse und der gewonnenen Erkenntnisse wurde entschieden, ein KI-gestütztes Kamerasystem für eine neue Maschinenkonzeption zu planen und einzuführen. Dieses System wird speziell darauf ausgelegt, die Qualitätssicherung weiter zu optimieren und eine noch präzisere Fehlererkennung in Echtzeit zu gewährleisten.

Sie haben Fragen zu diesem Projekt?

Dann freuen wir uns über eine Nachricht an:

Mittelstand-Digital Zentrum Hamburg

mittelstand-digital@haw-hamburg.de

Haben wir Ihr Interesse geweckt?

Wir bieten weitere Angebote zum Thema Qualitätskontrolle mit KI an.

Schauen Sie gerne in unsere Veranstaltungen rein.

Das Mittelstand-Digital Zentrum Hamburg gehört zu Mittelstand-Digital. Mit dem Mittelstand-Digital Netzwerk unterstützt das Bundesministerium für Wirtschaft und Energie die Digitalisierung in kleinen und mittleren Unternehmen und dem Handwerk. Kommen Sie gern auf uns zu, wir bringen Sie Digital Voraus!